前段時間喜歡用python去抓一些頁面玩,但都基本上都是用get請求一些頁面,再通過正則去過濾。

今天試了一下,模擬登陸個人網站。發現也比較簡單。讀懂本文需要對http協議和http會話有一定的理解。

注明:因為模擬登陸的是我的個人網站,所以以下代碼對個人網站和賬號密碼做了處理。

網站分析

爬蟲的必備第一步,分析目標網站。這里使用谷歌瀏覽器的開發者者工具分析。

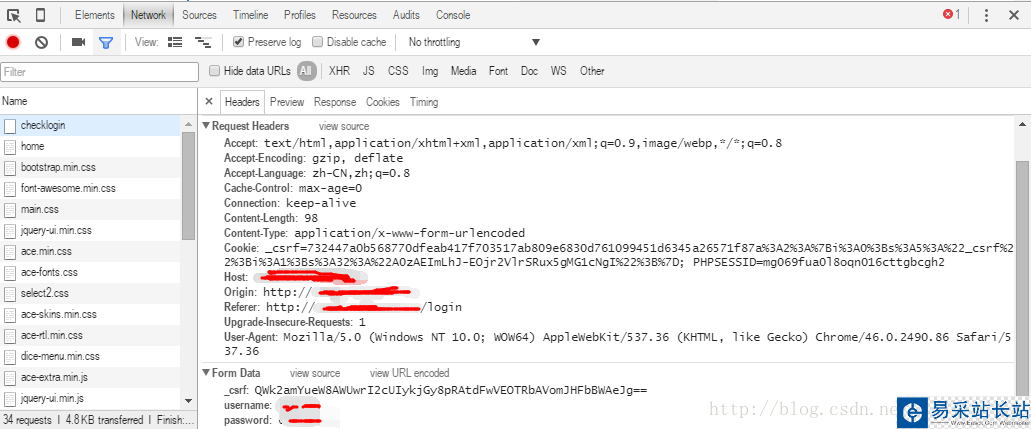

通過登陸抓取,看到這樣一個請求。

上方部分為請求頭,下面部分為請求是傳的參數。由圖片可以看出,頁面通過表單提交了三個參數。分別為_csrf,usermane,password。

其中csrf是為了預防跨域腳本偽造。原理很簡單,就是每一次請求,服務器生成一串加密字符串。放在隱藏的input表單中。再一次請求的時候,把這個字符串一起傳過去,為了驗證是否為同一個用戶的請求。

因此,我們的代碼邏輯就有了。首先請求一次登錄頁面。然后分析頁面,拿到csrf字符串。最后把這個字符串和賬號密碼一起傳給服務器用來登錄。

第一份代碼

#!/usr/bin/env python2.7# -*- coding: utf-8 -*-import requestsimport re# 頭部信息headers = { 'Host':"localhost", 'Accept-Language':"zh-CN,zh;q=0.8", 'Accept-Encoding':"gzip, deflate", 'Content-Type':"application/x-www-form-urlencoded", 'Connection':"keep-alive", 'Referer':"http://localhost/login", 'User-Agent':"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/46.0.2490.86 Safari/537.36"}# 登陸方法def login(url,csrf): data = { "_csrf" : csrf, "username": "xiedj", "password": "***" } response = requests.post(url, data=data, headers=headers) return response.content# 第一次訪問獲取csrf值def get_login_web(url): page = requests.get('http://localhost/login') reg = r'<meta name="csrf-token" content="(.+)">' csrf = re.findall(reg,page.content)[0] login_page = login(url,csrf) print login_pageif __name__ == "__main__": url = "http://localhost/login/checklogin" get_login_web(url)代碼看起來好像沒有什么問題。然而執行的時候出錯了。核查了一下,錯誤的原因是,csrf驗證失敗!

再多次確認獲取的csrf和請求登錄的csrf字符串沒問題了之后,我想到了一個問題。

如果,大家還不知道錯誤原因的話,這里可以暫停思考一個問題。“服務器如何知道,第一次請求獲取csrf和第二次post登錄請求是同一個用戶?”

到這,應該都清楚了,如果要登錄成功,需要解決如何讓服務相信兩次請求是同一個用戶。這里需要用到http會話(不清楚的可以自行百度,這里簡單介紹)。

http協議是一個種無狀態的協議。為了使這種無狀態變得有狀態,因此引進了會話。簡單的講,通過session去記錄這個狀態。當一個用戶第一次請求web服務的時候,服務器會生成一個session,用于保存這個用戶的信息。同時,在返回給用戶端時,把這個sessionID保存在cookies里。當用戶再一次請求的時候,瀏覽器會把這個cookies帶上。因此在服務器端就能知道多次請求是否為同一個用戶。

新聞熱點

疑難解答