1.安裝pip

我的個人桌面系統用的linuxmint,系統默認沒有安裝pip,考慮到后面安裝requests模塊使用pip,所以我這里第一步先安裝pip。

$ sudo apt install python-pip

安裝成功,查看PIP版本:

$ pip -V

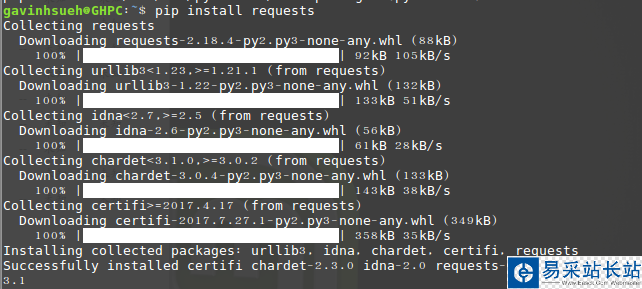

2.安裝requests模塊

這里我是通過pip方式進行安裝:

$ pip install requests

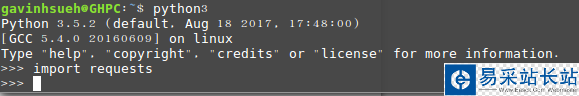

運行import requests,如果沒提示錯誤,那說明已經安裝成功了!

檢驗是否安裝成功

3.安裝beautifulsoup4

Beautiful Soup 是一個可以從HTML或XML文件中提取數據的Python庫。它能夠通過你喜歡的轉換器實現慣用的文檔導航,查找、修改文檔的方式。Beautiful Soup會幫你節省數小時甚至數天的工作時間。

$ sudo apt-get install python3-bs4

注:這里我使用的是python3的安裝方式,如果你用的是python2,可以使用下面命令安裝。

$ sudo pip install beautifulsoup4

4.requests模塊淺析

1)發送請求

首先當然是要導入 Requests 模塊:

>>> import requests

然后,獲取目標抓取網頁。這里我以下為例:

>>> r = requests.get('//www.jb51.net/article/124421.htm')這里返回一個名為 r 的響應對象。我們可以從這個對象中獲取所有我們想要的信息。這里的get是http的響應方法,所以舉一反三你也可以將其替換為put、delete、post、head。

2)傳遞URL參數

有時我們想為 URL 的查詢字符串傳遞某種數據。如果你是手工構建 URL,那么數據會以鍵/值對的形式置于 URL 中,跟在一個問號的后面。例如, cnblogs.com/get?key=val。 Requests 允許你使用 params 關鍵字參數,以一個字符串字典來提供這些參數。

舉例來說,當我們google搜索“python爬蟲”關鍵詞時,newwindow(新窗口打開)、q及oq(搜索關鍵詞)等參數可以手工組成URL ,那么你可以使用如下代碼:

>>> payload = {'newwindow': '1', 'q': 'python爬蟲', 'oq': 'python爬蟲'}>>> r = requests.get("https://www.google.com/search", params=payload)3)響應內容

通過r.text或r.content來獲取頁面響應內容。

>>> import requests>>> r = requests.get('https://github.com/timeline.json')>>> r.textRequests 會自動解碼來自服務器的內容。大多數 unicode 字符集都能被無縫地解碼。這里補充一點r.text和r.content二者的區別,簡單說:

resp.text返回的是Unicode型的數據;

新聞熱點

疑難解答