本文實例講述了Python爬蟲框架scrapy實現downloader_middleware設置proxy代理功能。分享給大家供大家參考,具體如下:

一、背景:

小編在爬蟲的時候肯定會遇到被封殺的情況,昨天爬了一個網站,剛開始是可以了,在settings的設置DEFAULT_REQUEST_HEADERS偽裝自己是chrome瀏覽器,剛開始是可以的,緊接著就被對方服務器封殺了。

代理:

代理,代理,一直覺得爬去網頁把爬去速度放慢一點就能基本避免被封殺,雖然可以使用selenium,但是這個坎必須要過,scrapy的代理其實設置起來很簡單。

注意,request.meta['proxy']=代理ip的API

middlewares.py

class HttpbinProxyMiddleware(object): def process_request(self, request, spider): pro_addr = requests.get('http://127.0.0.1:5000/get').text request.meta['proxy'] = 'http://' + pro_addr #request.meta['proxy'] = 'http://' + proxy_ip設置啟動上面我們寫的這個代理

settings.py

DOWNLOADER_MIDDLEWARES = { 'httpbin.middlewares.HttpbinProxyMiddleware': 543,}spiders

httpbin_test.py

import scrapyclass HttpbinTestSpider(scrapy.Spider): name = "httpbin_test" allowed_domains = ["httpbin.ort/get"] start_urls = ['http://httpbin.org/get'] def parse(self, response): print(response.text)

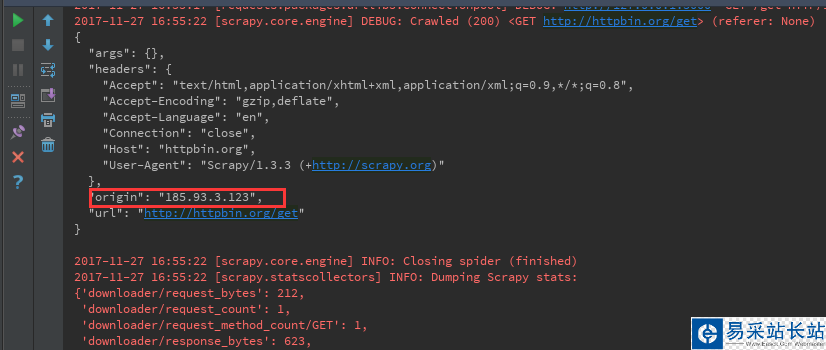

origin的值其實就是本地的公網地址,但是因為我們用了代理,這里的ip是美國的一個ip

二、那么問題來了,現在有這么一個場景,如上所述的話,我每個請求都會使用代理池里面的代理IP地址,但是有些操作是不需要代理IP地址的,那么怎么才能讓它請求超時的時候,再使用代理池的IP地址進行重新請求呢?

spider:

1、我們都知道scrapy的基本請求步驟是,首先執行父類里面(scrapy.Spider)里面的start_requests方法,

2、然后start_requests方法也是取拿我們設置的start_urls變量里面的url地址

3、最后才執行make_requests_from_url方法,并只傳入一個url變量

那么,我們就可以重寫make_requests_from_url方法,從而直接調用scrapy.Request()方法,我們簡單的了解一下里面的幾個參數:

1、url=url,其實就是最后start_requests()方法里面拿到的url地址

2、meta這里我們只設置了一個參數,download_timeout:10,作用就是當第一次發起請求的時候,等待10秒鐘,如果沒有請求成功的話,就會直接執行download_middleware里面的方法,我們下面介紹。

3、callback回調函數,其實就是本次的本次所有操作完成后執行的操作,注意,這里可不是說執行完上面所有操作后,再執行這個操作,比如說請求了一個url,并且成功了,下面就會執行這個方法。

新聞熱點

疑難解答