此次遇到的是一個函數使用不熟練造成的問題,但有了分析工具后可以很快定位到問題(此處推薦一個非常棒的抓包工具fiddler)

正文如下:

在爬取某個app數據時(app上的數據都是由http請求的),用Fidder分析了請求信息,并把python的request header信息寫在程序中進行請求數據

代碼如下

import requestsurl = 'http://xxx?startDate=2017-10-19&endDate=2017-10-19&pageIndex=1&limit=50&sort=datetime&order=desc'headers={ "Host":"xxx.com", "Connection": "keep-alive", "Accept": "application/json, text/javascript, */*; q=0.01", "User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/29.0.1547.59 Safari/537.36", "X-Requested-With": "XMLHttpRequest", "Referer": "http://app.jg.eastmoney.com/html_Report/index.html", "Accept-Encoding": "gzip,deflate", "Accept-Language": "en-us,en", "Cookie":"xxx"}r = requests.get(url,headers)print (r.text)請求成功但是,返回的是

{"Id":"6202c187-2fad-46e8-b4c6-b72ac8de0142","ReturnMsg":"加載失敗!"}就是被發現不是正常請求被攔截了

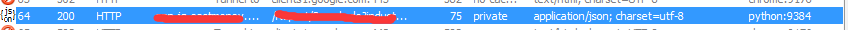

然后我去Fidder中看剛才python發送請求的記錄 #蓋掉的兩個部分分別是Host和URL。

然后查看請求詳細信息的時候,請求頭并沒有加載進去,User-Agent就寫著python-requests ! #請求頭里的UA信息是java,python程序,有點反爬蟲意識的網站、app都會攔截掉

Header詳細信息如下

GET http://xxx?istartDate=2017-10-19&endDate=2017-10-19&pageIndex=1&limit=50&sort=datetime&order=desc &Host=xxx.com &Connection=keep-alive &Accept=application%2Fjson%2C+text%2Fjavascript%2C+%2A%2F%2A%3B+q%3D0.01 &User-Agent=Mozilla%2F5.0+%28Windows+NT+6.1%3B+WOW64%29+AppleWebKit%2F537.36+%28KHTML%2C+like+Gecko%29+Chrome%2F29.0.1547.59+Safari%2F537.36 &X-Requested-With=XMLHttpRequest &Referer=xxx &Accept-Encoding=gzip%2Cdeflate &Accept-Language=en-us%2Cen &Cookie=xxxHTTP/1.1Host: xxx.comUser-Agent: python-requests/2.18.4Accept-Encoding: gzip, deflateAccept: */*Connection: keep-aliveHTTP/1.1 200 OKServer: nginx/1.2.2Date: Sat, 21 Oct 2017 06:07:21 GMTContent-Type: application/json; charset=utf-8Content-Length: 75Connection: keep-aliveCache-Control: privateX-AspNetMvc-Version: 5.2X-AspNet-Version: 4.0.30319X-Powered-By: ASP.NET

一開始還沒發現,等我把請求的URL信息全部讀完,才發現程序把我的請求頭信息當做參數放到了URL里

那就是我請求的時候request函數Header信息參數用錯了

又重新看了一下Requests庫的Headers參數使用方法,發現有一行代碼寫錯了,在使用request.get()方法時要把參數 “headers =“寫出來

更改如下:

import requestsurl = 'http://xxx?startDate=2017-10-19&endDate=2017-10-19&pageIndex=1&limit=50&sort=datetime&order=desc'headers={ "Host":"xxx.com", "Connection": "keep-alive", "Accept": "application/json, text/javascript, */*; q=0.01", "User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/29.0.1547.59 Safari/537.36", "X-Requested-With": "XMLHttpRequest", "Referer": "http://app.jg.eastmoney.com/html_Report/index.html", "Accept-Encoding": "gzip,deflate", "Accept-Language": "en-us,en", "Cookie":"xxx"}r = requests.get(url,headers=headers)

新聞熱點

疑難解答